有谁知道西安石油大学招生办王军老师的手机号码?王主任的电话谁敢公开啊?要是你分数线上了,应该没问题,打他电话没用,直接登录学校网站,打招生办电话吧安徽理工大学怎么样链接: 提

如何搭建基于tensorflow的深度语言服务器

如何学习在linux服务器上使用tensorflow

百度 linux安装tensorflow。 最直接有效的方法是看它提供的MINIST例子,然后一边看它的其它model的实现源码,一边自己上手写一些例子实践一下。自己如何搭建服务器。

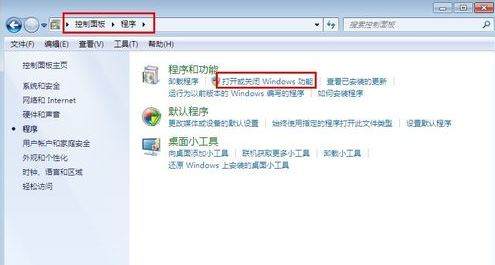

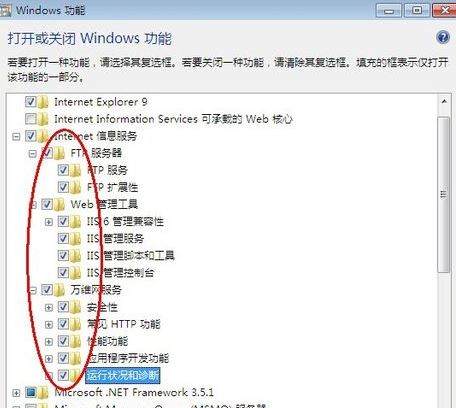

1、打开控制面板,选择并进入“程序”,双击“打开或关闭Windows服务”,在弹出的窗口中选择“Internet信息服务”下面所有地选项,点击确定后,开始更新服务。

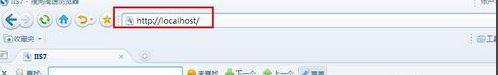

2、更新完成后,打开浏览器,输入“http://localhost/”回车,如果此时出现IIS7欢迎界面,说明Web服务器已经搭建成功。

3、当web服务器搭建成功后,我们下一步所要做的就是把我们开发的网站安装到Web服务器的目录中。一般情况下,当Web服务器安装完成后,会创建路径“%系统根目录%inetpub/wwwroot”,将我们开发的网站COPY到该路径下。即可实现本地访问该网站。

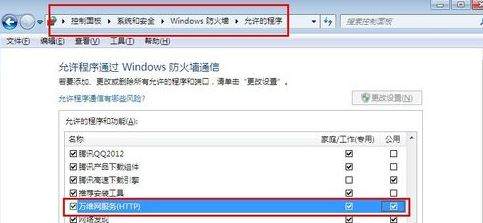

4、设置防火墙,让局域网当其它计算机也能访问本地网站资源。具体方法:打开控制面板,选择“系统和安全”,点击“允许程序通过Windows防火墙”,在弹出的对话框中勾选“万维网服务HTTP”右侧的两个复选框,最后点击确定退出。

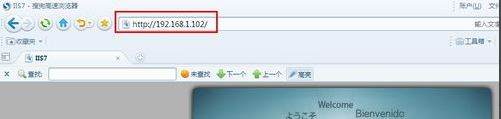

5、在局域网中其它计算机上,打开浏览器,输入 “http://Web服务器的IP地址/”按回车键,就可以访问服务器上的资源”。 经过以上步骤的设置,局域网中的其它用户就可以通过浏览器访问你所共享的web资源了!

扩展资料:

入门级服务器所连的终端比较有限(通常为20台左右),况且在稳定性、可扩展性以及容错冗余性能较差,仅适用于没有大型数据库数据交换、日常工作网络流量不大,无需长期不间断开机的小型企业。

不过要说明的一点就是目前有的比较大型的服务器开发、生产厂商在后面我们要讲的企业级服务器中也划分出几个档次,其中最低档的一个企业级服务器档次就是称之为"入门级企业级服务器",这里所讲的入门级并不是与我们上面所讲的"入门级"具有相同的含义,不过这种划分的还是比较少。

还有一点就是,这种服务器一般采用Intel的专用服务器CPU芯片,是基于Intel架构(俗称"IA结构")的,当然这并不是一种硬性的标准规定,而是由于服务器的应用层次需要和价位的限制。

如何配置一台深度学习主机

搞AI,谁又能没有“GPU之惑”?下面列出了一些适合进行深度学习模型训练的GPU,并将它们进行了横向比较,一起来看看吧!

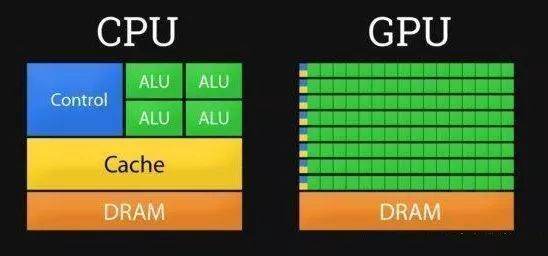

CPU与GPU对比

CPU是一个有多种功能的优秀领导者。它的优点在于调度、管理、协调能力强,计算能力则位于其次。而GPU相当于一个接受CPU调度的“拥有大量计算能力”的员工。

下图是处理器内部结构图:

DRAM即动态随机存取存储器,是常见的系统内存。

Cache存储器:电脑中作为高速缓冲存储器,是位于CPU和主存储器DRAM之间,规模较小,但速度很高的存储器。

算术逻辑单元ALU是能实现多组算术运算和逻辑运算的组合逻辑电路。

当需要对大数据bigdata做同样的事情时,GPU更合适,当需要对同一数据做很多事情时,CPU正好合适。

GPU能做什么?关于图形方面的以及大型矩阵运算,如机器学习算法等方面,GPU就能大显身手。

简而言之,CPU擅长统领全局等复杂操作,GPU擅长对大数据进行简单重复操作。CPU是从事复杂脑力劳动的教授,而GPU是进行大量并行计算的体力劳动者。

深度学习是模拟人脑神经系统而建立的数学网络模型,这个模型的最大特点是,需要大数据来训练。因此,对电脑处理器的要求,就是需要大量的并行的重复计算,GPU正好有这个专长,时势造英雄,因此,GPU就出山担当重任了。

太长不看版

截至2020年2月,以下GPU可以训练所有当今语言和图像模型:

- RTX 8000:48GB VRAM,约5500美元

- RTX 6000:24GB VRAM,约4000美元

- Titan RTX:24GB VRAM,约2500美元

- 以下GPU可以训练大多数(但不是全部)模型:

- RTX 2080 Ti:11GB VRAM,约1150美元

- GTX 1080 Ti:11GB VRAM,返厂翻新机约800美元

- RTX 2080:8GB VRAM,约720美元

- RTX 2070:8GB VRAM,约500美元

- 以下GPU不适合用于训练现在模型:

- RTX 2060:6GB VRAM,约359美元。

- 在这个GPU上进行训练需要相对较小的batch size,模型的分布近似会受到影响,从而模型精度可能会较低。

- GPU购买建议

- RTX 2060(6 GB):你想在业余时间探索深度学习。

- RTX 2070或2080(8 GB):你在认真研究深度学习,但GPU预算只有600-800美元。8 GB的VRAM适用于大多数模型。

- RTX 2080 Ti(11 GB):你在认真研究深度学习并且您的GPU预算约为1,200美元。RTX 2080 Ti比RTX 2080快大约40%。

- Titan RTX和Quadro RTX 6000(24 GB):你正在广泛使用现代模型,但却没有足够买下RTX 8000的预算。

- Quadro RTX 8000(48 GB):你要么是想投资未来,要么是在研究2020年最新最酷炫的模型。

- NV TESLA V100 (32GB):如果你需要在NVIDIA数据中心使用CUDA,那么TESLA就是必选品了。

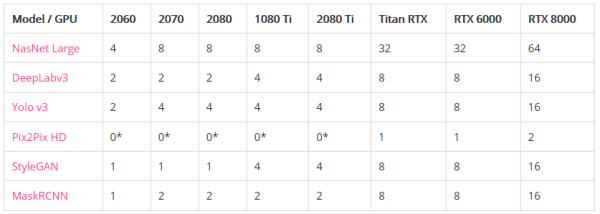

- 图像模型

- 内存不足之前的最大批处理大小:

- *表示GPU没有足够的内存来运行模型。

- 性能(以每秒处理的图像为单位):

- *表示GPU没有足够的内存来运行模型。

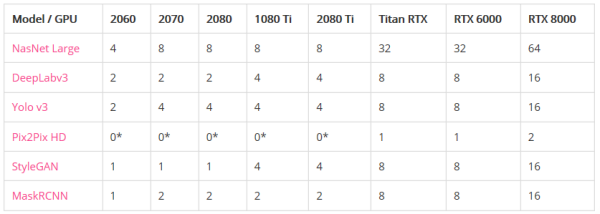

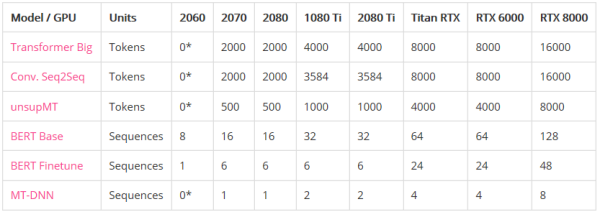

- 语言模型

- 内存不足之前的最大批处理大小:

- *表示GPU没有足够的内存来运行模型。

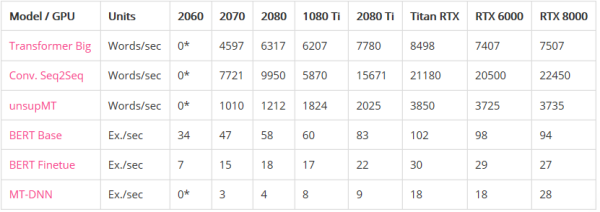

- 性能:

- * GPU没有足够的内存来运行模型。

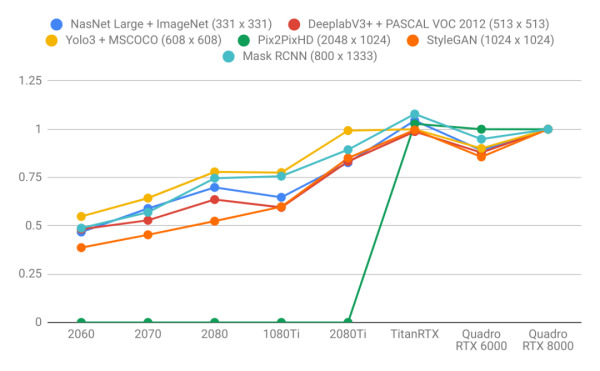

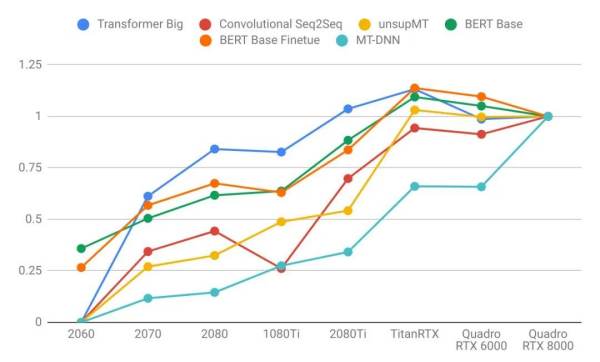

- 使用Quadro RTX 8000结果进行标准化后的表现

- 图像模型

- 语言模型

- 结论

- 语言模型比图像模型受益于更大的GPU内存。注意右图的曲线比左图更陡。这表明语言模型受内存大小限制更大,而图像模型受计算力限制更大。

- 具有较大VRAM的GPU具有更好的性能,因为使用较大的批处理大小有助于使CUDA内核饱和。

- 具有更高VRAM的GPU可按比例实现更大的批处理大小。只懂小学数学的人都知道这很合理:拥有24 GB VRAM的GPU可以比具有8 GB VRAM的GPU容纳3倍大的批次。

- 比起其他模型来说,长序列语言模型不成比例地占用大量的内存,因为注意力(attention)是序列长度的二次项。

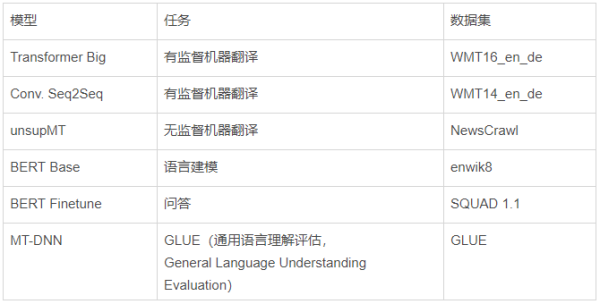

- 附注:测试模型

- 图像模型:

- 语言模型:

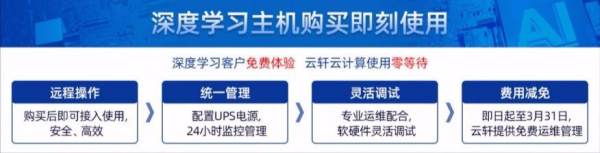

云轩Cloudhin专注Deep learning和高性能计算服务器定制,针对主要深度学习框架(如TensorFlow、Caffe 2、Theano或Torch)进行了优化和设置,在桌面上即可提供强大的深度学习功能。

请点击输入图片描述

请点击输入图片描述

神之手框架怎么用

使用开发神之手框架需要完成以下几个步骤: 1、下载开发神之手框架,可以从官网上下载,或者从GitHub下载; 2、安装开发神之手框架,可以使用Pip命令进行安装; 3、初始化项目,可以使用“神之手”命令行工具来完成; 4、添加模块,可以使用“神之手”命令行工具或编辑配置文件来完成; 5、编写代码,可以使用Python语言或其他语言; 6、使用“神之手”命令行工具来构建项目; 7、发布应用,可以使用“神之手”命令行工具或者使用第三方持续集成工具来完成。如何选择深度学习框架 TensorFlow/Torch/Mxnet/Theano

深度学习目前的应用领域很多,主要是计算机视觉和自然语言处理,以及各种预测等。对于计算机视觉,可以做图像分类、目标检测、视频中的目标检测等,对于自然语言处理,可以做语音识别、语音合成、对话系统、机器翻译、文章摘要、情感分析等。 对于刚入行深度学习,想从事人工智能工业应用和研发的小白来说,选择一个适合自己的深度学习框架显得尤为重要。那么在选择深度学习框架的时候,要注意哪些内容呢? 通常我们在选择框架时要考虑易用性、性能、社区、平台支持等问题。初学者应该考虑容易上手的框架,偏工业应用的开发者可以考虑使用稳定性高、性能好的框架,偏研究性的开发者,一般选择易用而且有领先的模型基线的框架。 目前这个阶段相关文章

- 详细阅读

-

计算机发生蓝屏故障时,用户应注意收详细阅读

电脑蓝屏并出现你的电脑遇到问题需要重新启动,我们只收集这些错误信电脑蓝屏:又叫蓝屏死机(Blue Screen of Death,简称BSOD),是微软的 Windows 系列操作系统在无法从一个系统错误

-

Internet网中不同网络和不同计算机详细阅读

internet上各种网络和不同计算机间相互通信的基础是()协议internet上各种网络和不同计算机间相互通信的基础是TCP/IP协议。TCP/IP是因特网的正式网络协议,是一组在许多独立主机

- 详细阅读

-

无法启动此程序因为计算机中丢失DD详细阅读

无法启动此程序,因为计算机中丢失是因为你的电脑缺少了这个组件,你用360安全卫士把这个补丁打上就可以使用了。

以找另一台的电脑上去复制下这个缺失的文件,看看能否解决问题 -

如果手机的sd卡有病毒(计算机病毒),那详细阅读

我的华为畅享五无法读128G内存卡,为什么呢?怎样解决呢?1、建议您关机后重新插拔一次MicroSD卡后再开机尝试(部分机型不支持热插拔,必须关机时插入MicroSD卡或者插卡后重启手机)。

-

照片查看器无法显示此图片,因为计详细阅读

Windows照片查看器无法打开照片,显示内存不够,可是我还有很多的内存!出现该情况原因是当该软件的环境变量中的TMP位于磁盘剩余空间较小的磁盘,可以在系统设置中将其修改为剩余空

- 详细阅读

- 详细阅读

-

计算机网络工程有哪些?详细阅读

计算机网络工程有哪些?计算机网络工程类包括计算机科学与技术,网络工程,电子商务等三大本科专业为依托,具体还分为:离散数学,数据结构,操作系统,数据库系统,计算机组成原理,微机与接口